Évaluation ouverte de la recherche

Résumé de section

-

-

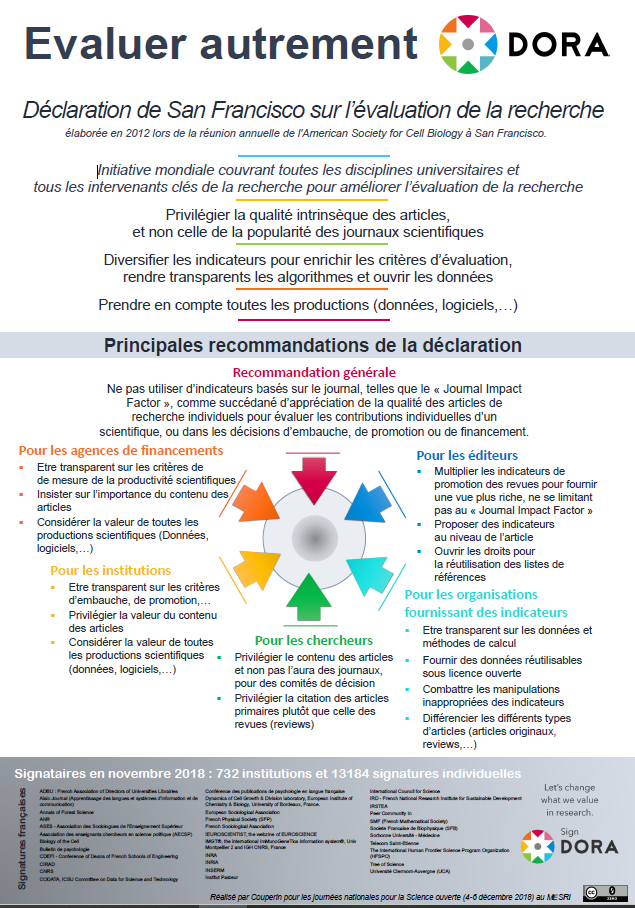

La Déclaration de San Francisco sur l’évaluation de la recherche (San Francisco Declaration on Research Assessment, DORA, 2012) et le Manifeste de Leiden (2015) visent à améliorer les pratiques d’évaluation des activités de recherche, alertant notamment sur le mauvais usage de certains indicateurs bibliométriques.

Déclaration de DORA

Afin de répondre à la question de l'amélioration des méthodes d’évaluation des résultats de la recherche scientifique par les agences de financement, les établissements d’enseignement et de recherche, un groupe de rédacteurs en chef et d’éditeurs de revues savantes s’est réuni à San Francisco en Californie le 16 décembre 2012, dans le cadre du congrès annuel de l’American Society for Cell Biology (ASCB). Ce groupe a élaboré un ensemble de recommandations, désormais appelé « Déclaration de San Francisco sur l’évaluation de la recherche ».

Ces recommandations s’articulent autour d’un certain nombre de sujets :

- la nécessité de mettre un terme à l’utilisation d’indicateurs basés sur les revues, comme les facteurs d’impact, dans le financement, les nominations et les promotions ;

- celle d’évaluer la recherche sur sa valeur intrinsèque plutôt qu’en fonction de la revue où elle est publiée ;

- celle encore d’exploiter au mieux les possibilités offertes par la publication en ligne (comme la levée de restrictions inutiles sur le nombre de mots, de figures et de références dans les articles et l’exploration de nouveaux indicateurs d’importance

et d’impact).

- En février 2024, 21 480 personnes et 3 095 organisations dans 165 pays ont signé DORA.

- En France, 1352 personnes et 88 organisations ont signé cette déclaration.

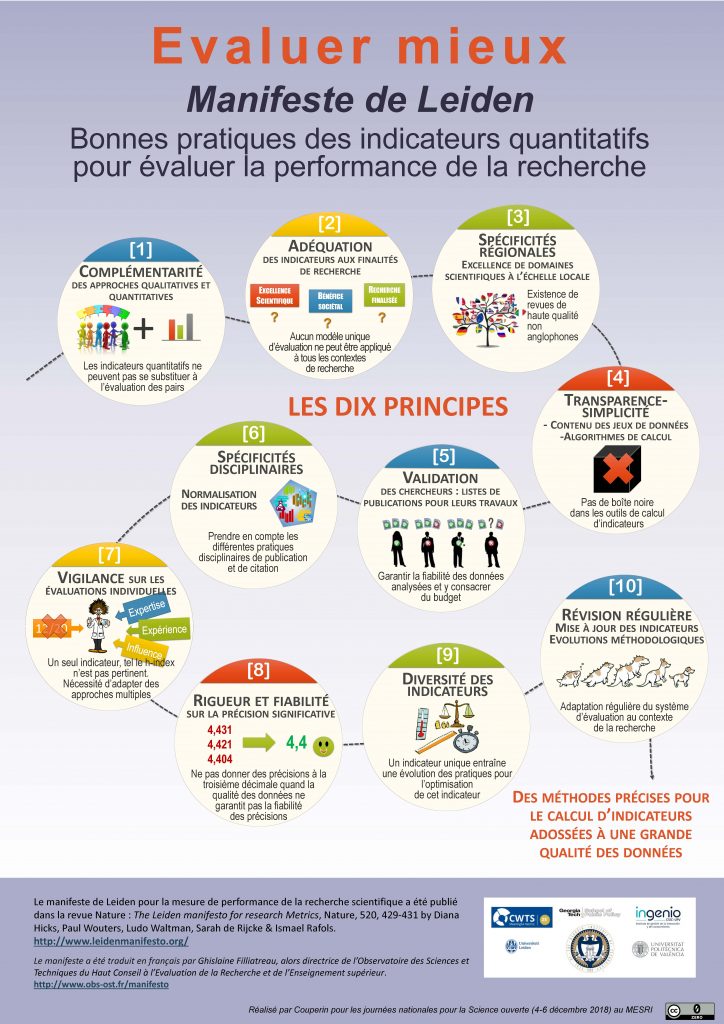

Manifeste de Leiden

Le Manifeste de Leiden pour une meilleure utilisation des indicateurs d'évaluation de la recherche est une liste de «dix principes pour guider l'évaluation de la recherche», publiée sous forme de commentaire dans le volume 520, numéro 7548 de Nature , le 22 avril 2015.

Un accord pour la réforme de l'évaluation européenne de la recherche (CoARA)

Annoncée le 20 juillet 2022, la version finale de l’accord pour la réforme de l’évaluation de la recherche a été présentée lors d’une assemblée des différentes parties prenantes regroupant plus de 350 organisations de plus de 40 pays parmi lesquelles se trouvent de nombreux établissements français. L’accord est le résultat d’un travail de co-rédaction mené par l’European University Association, Science Europe et la Commission européenne.

L’accord définit une orientation commune pour modifier les pratiques d’évaluation de la recherche, des chercheurs et des organismes de recherche, l’objectif principal étant de maximiser la qualité et l’impact de la recherche. Ainsi, l’accord comprend les principes, les engagements et le calendrier des réformes et définit les principes d’une coalition d’organisations désireuses de travailler ensemble à la mise en œuvre des changements. Cette nouvelle coalition se nomme CoARA.

Les 4 principaux engagements :

- Reconnaître la diversité des contributions à la recherche et des carrières dans la recherche, conformément aux besoins et à la nature de la recherche ;

- Fonder l’évaluation de la recherche principalement sur une évaluation qualitative pour laquelle l’examen par les pairs est central, soutenu par une utilisation responsable d’indicateurs quantitatifs ;

- Abandonner les utilisations inappropriées dans l’évaluation de la recherche des mesures basées sur les revues et les publications, en particulier les utilisations inappropriées du facteur d’impact des revues (JIF) et du h-index ;

- Éviter l’utilisation des classements des organismes de recherche dans l’évaluation de la recherche.

L’accord est soumis à signature à partir du 28 septembre 2022. Les organismes impliqués dans l’évaluation de la recherche, basés en Europe ou ailleurs, sont encouragés à le signer et à rejoindre ensuite la coalition.

La publication de cet accord s’inscrit dans un mouvement global dans lequel on compte plus d’une dizaine d’initiatives comme récemment l’Appel de Paris sur l’évaluation de la recherche ou les conclusions du Conseil sur l’évaluation de la recherche et la mise en œuvre de la science ouverte.

-

L'Open Peer Review : nouvelle méthode d'évaluation ouverte par les pairs

En parallèle de ce mouvement de réforme des indicateurs d'évaluation de la recherche, de nouvelles méthodes d'évaluation ouverte des productions scientifiques apparaissent autour de l'Open Peer Review ou évaluation ouverte par les pairs.Celui-ci prend le contrepied du traditionnel Blind peer review (évaluation à l'aveugle) dans lequel les auteurs et évaluateurs ignorent leurs identités respectives. A l'inverse, l'Open Peer Review offre la possibilité de connaitre les identités des auteurs et évaluateurs et de rendre public les rapports et échanges entre les acteurs directement sur la plateforme de l'éditeur (exemple PLOS). Cela permet de rendre plus transparent le travail des évaluateurs, de prévenir les conflits d'intérêts et de valoriser le temps consacrer à l'évaluation des articles.

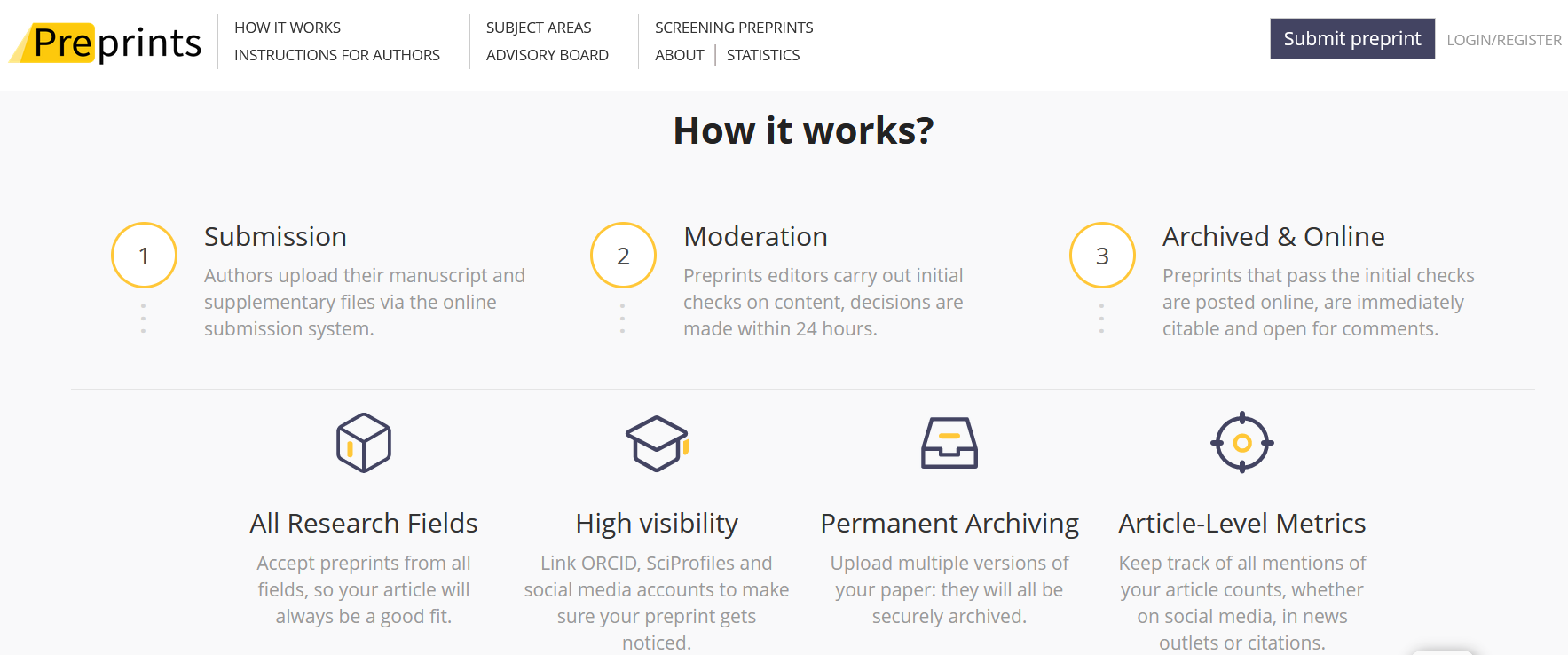

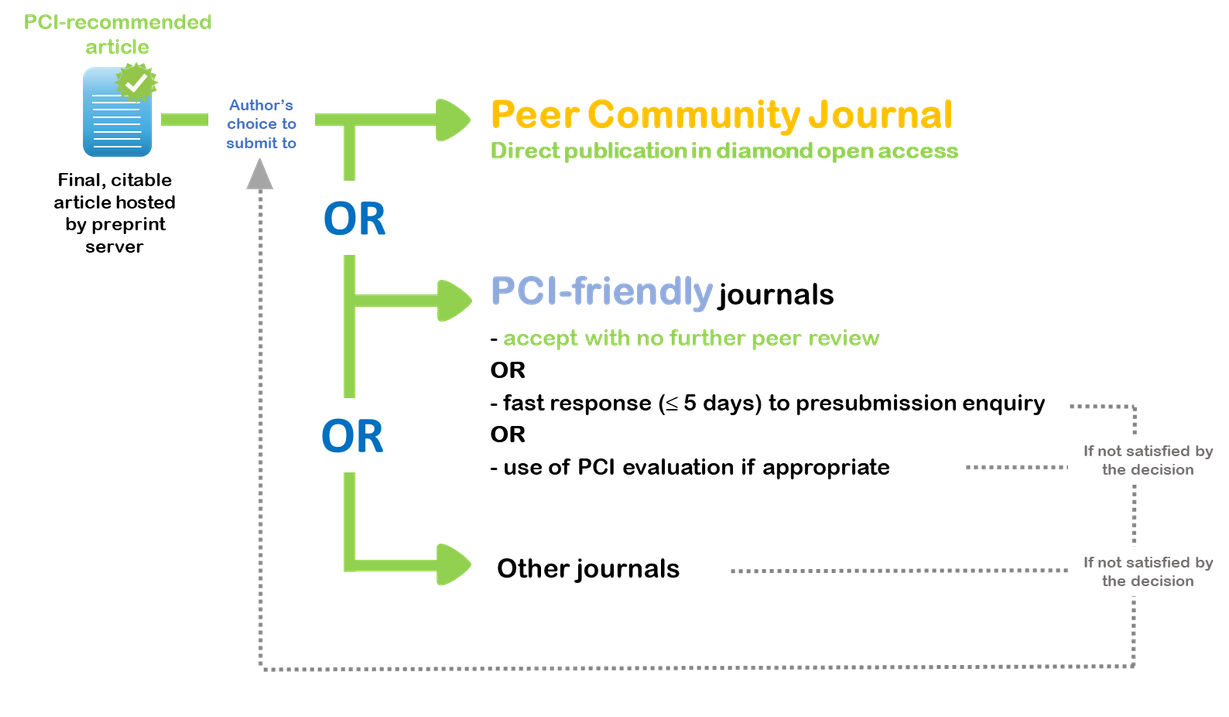

Certains serveurs de pre-prints permettent également de commenter les documents déposés, ce qui peut êtreconsidéré comme une forme d'Open Peer Review. (Preprints.org par exemple) Autre initiative intéressante, celle de Peer Community In (PCI) depuis 2017 qui propose par discipline un service de recommandation de pre-prints basées sur des évaluations par les pairs. Depuis 2021, ces articles recommandés peuvent être publiés dans la revue Peer community journal ou dans d'autres revues, notamment des épi-revues.

Autre initiative intéressante, celle de Peer Community In (PCI) depuis 2017 qui propose par discipline un service de recommandation de pre-prints basées sur des évaluations par les pairs. Depuis 2021, ces articles recommandés peuvent être publiés dans la revue Peer community journal ou dans d'autres revues, notamment des épi-revues.

Enfin, l'évaluation ouverte peut être proposée en post-publication pour certaines revues qui rendent visibles les rapports et offrent la possibilité d'annoter un article publié et d'afficher les commentaires directement sur l'article (exemple de la revue e-life et outil Hypothes.is). C'est également le rôle de la plateforme PubPeer, avec la limite toutefois de pouvoir proposer des contributions anonymes. Les discussions autour de certains articles sur PubPeer entrainent parfois la rétractation de l'article, suivi par le collectif Retraction Watch.

Enfin, l'évaluation ouverte peut être proposée en post-publication pour certaines revues qui rendent visibles les rapports et offrent la possibilité d'annoter un article publié et d'afficher les commentaires directement sur l'article (exemple de la revue e-life et outil Hypothes.is). C'est également le rôle de la plateforme PubPeer, avec la limite toutefois de pouvoir proposer des contributions anonymes. Les discussions autour de certains articles sur PubPeer entrainent parfois la rétractation de l'article, suivi par le collectif Retraction Watch. -

Vérifiez vos connaissances

-