Chapitre 3 : Cadre juridique et éthique

Résumé de section

-

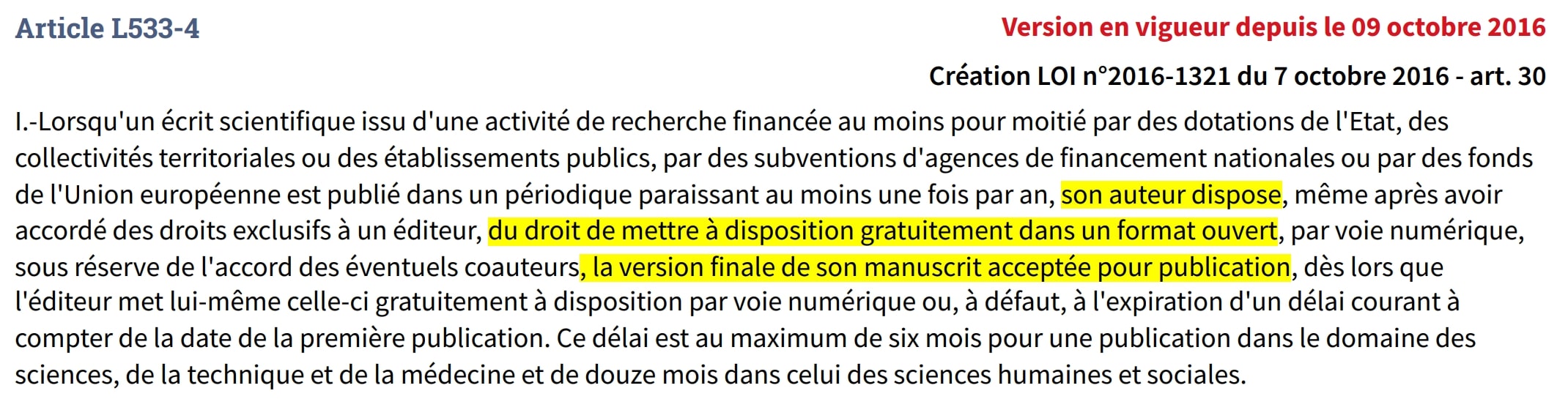

Face aux tensions identifiées entre IA et science ouverte, il est essentiel de comprendre le cadre juridique qui encadre ces pratiques et les enjeux éthiques qu'elles soulèvent. Ce chapitre explore les règles existantes, les droits des chercheurs et les questions de responsabilité qui émergent dans ce nouveau paysage numérique.

10 minutes de lecture