Intelligence Artificielle et Science Ouverte : tension ou complémentarité ?

Résumé de section

-

Ce cours est adapté du webinaire "L'IA risque-t-elle de remettre en cause la science ouverte ?" (#OAW25) organisé par le réseau des bibliothèques universitaires de Toulouse-Albi dans le cadre de la semaine "Ouvrez-la ! Toul'AO pour une Science Ouverte" (31 mars - 4 avril 2025).

Il s'appuie sur les interventions de trois experts de l'Université Toulouse-Capitole :

- Michel Fraysse, Conservateur en chef des bibliothèques, responsable du Département des services à la recherche au SCD

- Rim-Sarah Alouane, Docteure en droit public, rattachée à l'Institut du Droit de l'Espace des Territoires, de la Culture et de la Communication (IDETCOM), spécialiste des droits et libertés fondamentaux

- Laïsa Ferreira, Docteure en droit privé, rattachée au Centre de Droit des Affaires, spécialiste du droit de la propriété intellectuelle et du numérique

Objectifs généraux

- Identifier les points de friction entre IA et science ouverte

- Analyser les craintes légitimes des chercheurs face à l'IA

- Reconnaître les biais et erreurs de l'IA (hallucinations, biais algorithmiques)

- Comprendre les enjeux juridiques (droit d'auteur, RGPD, IA Act)

- Évaluer les conséquences éthiques (inégalités, privatisation du savoir)

- Contribuer à une science ouverte compatible avec l'IA

Ce cours est en libre accès !

Aucune création de compte ou d'inscription n'est nécessaire. Bonne lecture !

-

L'usage de l'intelligence artificielle générative est aujourd'hui présent dans beaucoup de secteurs, y compris la recherche scientifique. Michel Fraysse pose la question centrale : "En quoi l'irruption des outils d'intelligence artificielle générative change-t-elle la donne par rapport à la science ouverte ?"

20 minutes de lecture

-

Si l'IA peut effectivement servir la science ouverte, son utilisation dans le champ académique n'est pas sans risque. Comme le souligne Rim-Sarah Alouane : "Cette efficacité soulève également quelques inquiétudes quant aux dérives potentielles d'une automatisation excessive du processus scientifique, notamment en termes de rigueur méthodologique et d'intégrité intellectuelle."

20 minutes de lecture

-

Face aux tensions identifiées entre IA et science ouverte, il est essentiel de comprendre le cadre juridique qui encadre ces pratiques et les enjeux éthiques qu'elles soulèvent. Ce chapitre explore les règles existantes, les droits des chercheurs et les questions de responsabilité qui émergent dans ce nouveau paysage numérique.

10 minutes de lecture

-

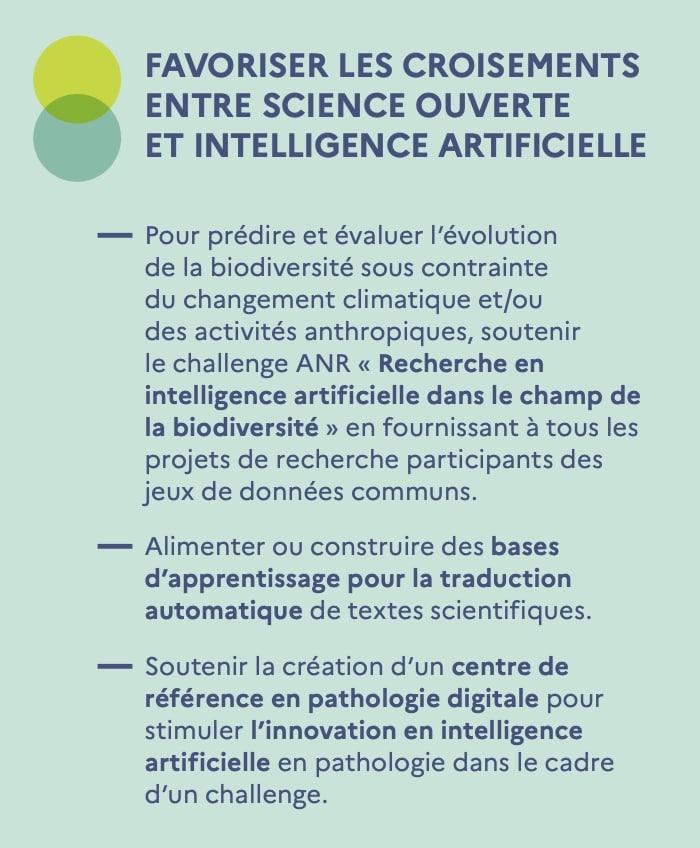

Après avoir identifié les tensions et analysé le cadre juridique, comment agir concrètement ? Ce dernier module présente les stratégies recommandées par nos experts, les exemples inspirants et les perspectives d'avenir pour une cohabitation harmonieuse entre IA et science ouverte.

10 minutes de lecture

-