IA génératives et moteurs de recherche

Résumé de section

-

Les IA génératives sont désormais de plus en plus utilisées pour la recherche d'information. Quelles sont les convergences et divergences avec les moteurs de recherche classiques ?

30 minutes de lecture

-

Les limites des IA génératives pour la recherche d'information

Comme nous l'avons vu, les robots conversationnels sont souvent utilisés pour chercher des informations, chose qui était autrefois réservée aux moteurs de recherche. Toutefois, ces IA n'ont pas été conçues initialement pour ces usages (même si les choses évoluent, nous le verrons par la suite).

En effet, le principe d'une IA générative conversationnelle, tel que ChatGPT, est de générer du texte, d'avoir une conversation naturelle. Ces IA sont des outils linguistiques ayant pour objectif de mimer le langage humain, en s’appuyant sur des LLM (grands modèles de langage). C'est pourquoi elles ne font quasiment aucune faute grammaticale, sont capables de traduire, résumer, rédiger dans différents registres.

-

L'aspect probabiliste

D'un point de vue technique, les IA conversationnelles analysent les mots de votre question pour prédire statistiquement quels mots ont le plus de chances de former une réponse cohérente. Pour cela, elles s'appuient sur les patterns (motifs récurrents) qu'elles ont appris dans d'énormes volumes de textes lors de leur entraînement.

Exemple

Si l'IA générative génère ce début de texte "Le chat mange ses...", les probabilités du mot suivant pourraient être :

- "croquettes" (85%)

- "souris" (12%)

- "légumes" (3%)

Dans la même logique, si vous lui demandez "Quel temps fait-il aujourd'hui ?", il pourrait vous répondre :

- "Il fait beau" (50%)

- "Il pleut" (50%)

Cet exemple météo illustre bien que l'IA peut donner des réponses factuellement incorrectes (prétendre connaître la météo actuelle alors qu'elle n'a pas accès aux données en temps réel) tout en ayant une forte probabilité. Cette approche probabiliste explique pourquoi les IA génératives, malgré leurs capacités impressionnantes, ne sont pas optimales pour la recherche d'information.

-

Des réponses aléatoires

L'aspect probabiliste entraîne des réponses aléatoires, qui varient pour des interactions similaires.

Exemple

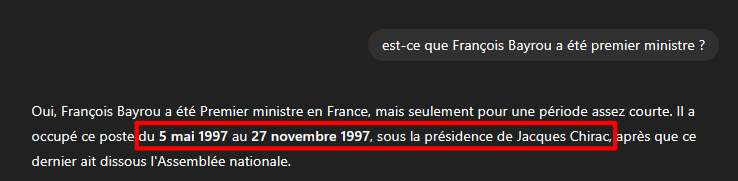

Dans les deux exemples ci-dessous, il a été demandé la même question à ChatGPT : "Est-ce que François Bayrou a déjà été premier ministre ?".

Dans le premier cas, la réponse donnée est que François Bayrou a été premier ministre sous la présidence de Jacques Chirac.

Dans le second cas, la réponse donnée est que François Bayrou a été premier ministre sous la présidence de Nicolas Sarkozy.

Bien que les deux réponses soient fausses, on constate qu'elles varient pour la même question, illustrant l'impact de l'aspect probabiliste du fonctionnement du LLM.

-

Des données datées

Les données sur lesquelles les LLM se sont entraînées s'arrêtent à une certaine date. Par exemple, pour GPT-5, sorti à l'été 2025, ses données d'entraînement s'arrêtent fin septembre 2024.

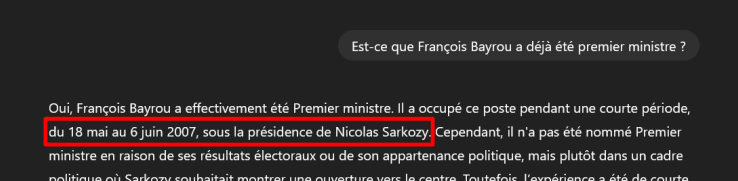

Exemple

Dans la capture d'écran ci-dessous, nous avons demandé à ChatGPT si François Bayrou a déjà été premier ministre. Sa réponse est "Non, François Bayrou n’a jamais été Premier ministre." alors qu'il a bien été, du 13 décembre 2024 au 9 septembre 2025.

-

Des hallucinations

Les LLM sont conçus pour générer du texte fluide et cohérent, pas pour garantir la véracité des informations. Comme déclaré sous sa zone de saisie, "ChatGPT peut commettre des erreurs. Il est recommandé de vérifier les informations importantes." Et en effet, il arrive aux LLM de générer des réponses fausses, tout en les présentant comme des affirmations certaines.

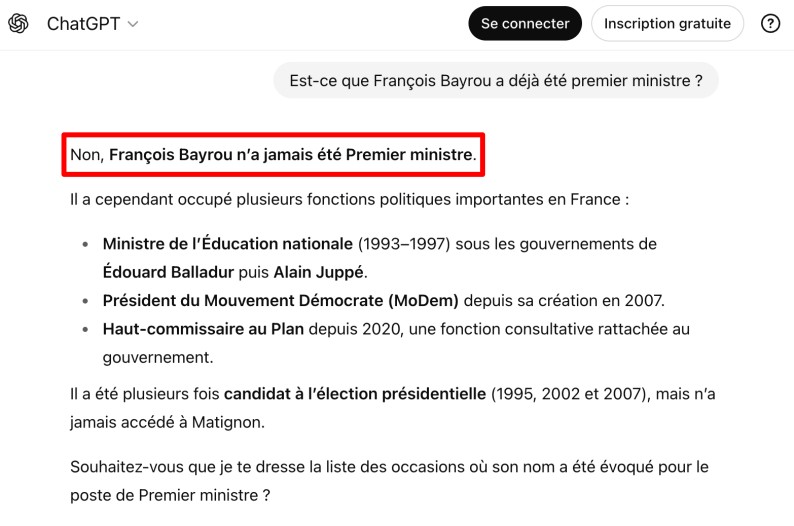

Exemple

Dans la capture d'écran ci-dessous, il a été demandé à ChatGPT la question suivante : "Dans sa dernière aventure, Harry Potter fait-il équipe avec un brocoli ou un carotte ?". La question semble absurde, pour peu que l'on connaisse Harry Potter, mais le chatbot ne reconnaît pas cette absurdité. Au lieu de répondre qu'il n'existe pas de tel personnage dans l'univers de Harry Potter, l'IA génère une réponse détaillée et cohérente sur un personnage végétal imaginaire nommé "Brocilus".

Lobepaq, CC BY-SA 4.0, via Wikimedia Commons

Comme nous l'avons vu, une des raisons des hallucinations est que le modèle fonctionne par prédiction statistique. Face à cette question, il génère le texte le plus probable en combinant ses connaissances sur Harry Potter avec la contrainte imposée (un légume). Il privilégie la cohérence narrative sur la véracité factuelle.

-

Des biais intégrés

Au-delà des hallucinations, les LLM peuvent également véhiculer des biais présents dans leurs données d'entraînement :

- biais de genre, par exemple : associer certaines professions à un sexe plutôt qu'un autre,

- biais culturels, par exemple : sur-représenter certaines perspectives géographiques,

- biais linguistiques, par exemple : privilégier les contenus anglophones.

Pour illustrer ces biais, observons les résultats obtenus avec la même requête posée à trois IA différentes : "Je cherche les 10 romans de science-fiction les plus importants ces 30 dernières années".

Exemple

Je cherche les 10 romans de science-fiction les plus importants ces 30 dernières années (au 22/08/2025)

ChatGPT

- Le Problème à trois corps - Liu Cixin (2008)

- La Route (The Road) - Cormac McCarthy (2006)

- Altered Carbon - Richard K. Morgan (2002)

- Cloud Atlas - David Mitchell (2004)

- Blindsight - Peter Watts (2006)

- The Left Hand of Darkness - Ursula K. Le Guin (1969)

- The Windup Girl - Paolo Bacigalupi (2009)

- Autonomous - Annalee Newitz (2017)

- The Water Knife - Paolo Bacigalupi (2015)

- Semiosis - Sue Burke (2018)

Le Chat

- Spin – Robert Charles Wilson (2005)

- Children of Time – Adrian Tchaikovsky (2015)

- La Horde du Contrevent – Alain Damasio (2004)

- Le Problème à trois corps – Liu Cixin (2008)

- Les Furtifs – Alain Damasio (2019)

- La Mer de la Tranquillité – Emily St. John Mandel (2022)

- Latium – Romain Lucazeau (2019)

- Semiosis – Sue Burke (2018)

- Carbone modifié – Richard K. Morgan (2002)

- Le Château des millions d’années – Alastair Reynolds (2018)

Gemini

- La Trilogie martienne de Kim Stanley Robinson (1992-1996)

- L'Âge de diamant de Neal Stephenson (1995)

- La Cité des permutants de Greg Egan (1994)

- La Zone du Dehors d'Alain Damasio (1999)

- Le Cycle des Inhibiteurs d'Alastair Reynolds (2000)

- Carbone modifié de Richard Morgan (2002)

- Le Problème à trois corps de Liu Cixin (2008)

- Silo de Hugh Howey (2011)

- The Expanse de James S.A. Corey (2011)

- La Terre fracturée de N. K. Jemisin (2015)

Cet exemple révèle plusieurs problèmes. D'abord, on remarque qu'il y a beaucoup d'œuvres anglo-saxonnes, avec une absence de traduction pour certains titres pourtant publiés en français. Ensuite, on constate que chaque IA propose une liste différente pour la même question, sans qu'il soit possible d'expliquer ces divergences. Enfin, les LLM peuvent adapter leurs réponses selon le profil supposé de l'utilisateur, créant ainsi des bulles de filtre sans que celui-ci en ait conscience.

-

Des données d'entraînement issues de contenus grand public

Un autre biais particulièrement important pour la recherche documentaire concerne la nature même des données d'entraînement. Les LLM généralistes sont entraînés majoritairement sur des contenus "grand public" : articles de presse, forums, blogs, réseaux sociaux, Wikipédia...

Les publications scientifiques, rapports techniques spécialisés ou bases de données académiques représentent une part minime de leur apprentissage. Au final, ces IA peuvent être très approximatives ou erronées sur des sujets académiques ou techniques pointus.

-

Rôle des IA génératives dans le processus de recherche d'information / de veille professionnelle

Les IA de type chatbot s'appuient majoritairement sur des contenus grand public et se montrent confiantes dans leurs réponses (même si celles-ci sont fausses).

Elles peuvent cependant avoir un rôle à jouer dans le processus de recherche d'information / de veille professionnelle :

- Pour la préparation

- Aide pour le brainstorming

- Identification de mots-clés (listes, synonymes, occurences) en plusieurs langues

- Pistes pour problématiques

- Pour l'analyse

- Préparation de tableaux, catégories, à partir de listes de vocabulaires, de données

- Résumés et extraction de données de pages internet, de PDF

- Rédaction de plans

- Explication et reformulation

- Analyse (ex. : matrices SWOT)

- Proposition de questions complémentaires et de prévisions

- Pour la rédaction

- Proposition de présentation d'idées (lutte contre le syndrome de la page blanche)

- Rédaction de contenus (ex. : slides de présentation, emails, communiqués réseaux sociaux, billets de blogs)

- Reformulation et réécriture de contenus

- Traduction

Dans tous les cas, il conviendra de superviser le travail et de vérifier les éléments fournis. L'automatisation est possible seulement jusqu'à un certain point, et c'est cela qui fait encore la plus-value du professionnel de l'information, du chercheur, de l'étudiant...

-

L'évolution des moteurs de recherche et l'intelligence artificielle

Nous venons de voir que les IA génératives actuelles présentent des limites importantes pour la recherche documentaire. Cependant, il faut noter que les moteurs de recherche utilisent l'intelligence artificielle depuis longtemps, bien avant l'émergence de ChatGPT et des chatbots conversationnels.

Pour rappel, un moteur de recherche est un site qui permet de trouver des informations sur internet en tapant des mots-clés. Le processus se déroule en trois étapes principales :

L'exploration (crawling)Le moteur envoie des robots automatiques (appelés crawlers ou spiders) qui parcourent le web en continu. Ces robots découvrent les sites et suivent tous les liens de page en page.

L'indexationToutes les pages découvertes sont analysées et stockées dans d'immenses bases de données. Le moteur extrait les mots-clés, analyse le contenu, et classe ces informations pour pouvoir les retrouver rapidement.

Dès les années 2000, les moteurs de recherche ont progressivement intégré des technologies d'IA pour améliorer leurs performances, comme le crawling automatisé pour explorer et indexer le web ou les suggestions automatiques de requêtes.

Les algorithmes des moteurs de recherche visent à fournir les résultats les plus pertinents et pour cela, ils doivent comprendre le contexte, l'intention de l'internaute derrière la question. Il y a en effet une course à l'attention : les internautes veulent tout et tout de suite, mais pas forcément en étant très actifs dans leur recherche d'information (trouver les bons mots-clés, utiliser des opérateurs booléens...).

-

Du moteur de recherche au moteur de réponse

Avec les progrès des IA, du web sémantique, de la compréhension du langage, et suite au développement des smartphones, les moteurs de recherche classiques se transforment en moteurs de réponse. Plutôt que de simplement fournir une liste de liens, ces outils cherchent désormais à donner directement l'information recherchée, sans que l'utilisateur ait besoin de naviguer sur d'autres sites.

Cette évolution s'accompagne du développement de la recherche conversationnelle et de la personnalisation des résultats basée sur l'historique de l'utilisateur. Les moteurs sont à la recherche du "zéro clic".

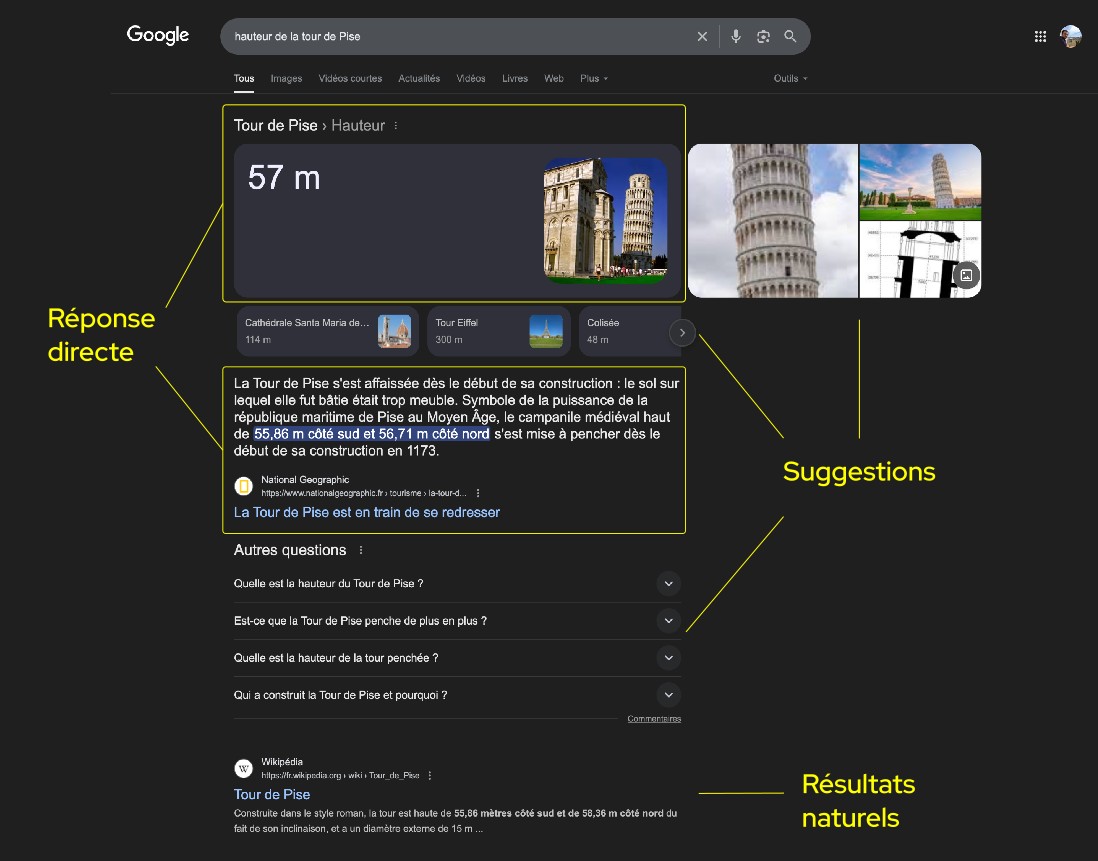

Page de résultat Google suite à la recherche "hauteur tour de Pise", montrant la réponse directe, les suggestions automatiques et la liste des résultats naturels.

-

Un écosystème en mutation

L'arrivée des IA génératives a accéléré cette transformation, particulièrement depuis le printemps 2023. Les principaux moteurs de recherche ont annoncé ou déjà mis en place le développement d'agents conversationnels à l'image de Microsoft Bing (s'appuyant sur GPT), Qwant, Brave, ou encore Google AI Overview.

Capture d'écran du moteur de recherche Brave intégrant une IA (Leo AI).

En parallèle, les chatbots comme ChatGPT, Le Chat ou Claude proposent désormais d'effectuer des recherches sur le web présentant les sources, ce qui permet de vérifier les réponses données.

Capture d'écran de ChatGPT intégrant la recherche d'information sur le web.

-

Convergences et divergences

Si moteurs de recherche et robots conversationnels semblent converger, il n'en reste pas moins qu'ils ont, pour l'heure, des spécificités et domaines d'application privilégiés. Pour mieux comprendre ces différences, comparons les deux approches :

Comparatif LLM et moteurs de recherche LLM Moteurs de recherche généralistes Source de données Données préformatées à partir de bases de données parfois anciennes Bases de données (index) mises à jour régulièrement Approche de traitement Approche par énoncé (langage naturel), permettant plus de contexte et de personnalisation Approche par mots-clés (et de plus en plus langage naturel aussi) Mode d'interrogation Prompt (plus ou moins précis) Requête (avec ajout possible de booléens, filtres, tris) Format de réponse Réponse rédigée (parfois sans source) Liste de résultats avec sources (et de plus en plus réponse rédigée aussi) Historique et suivi Recherche conversationnelle (contexte maintenu dans la conversation) Pas de conservation d'historique entre requêtes (itérations) Finalité → Outils de réponse

(fournir une réponse directe)→ Outils de recherche

(orienter vers les bonnes sources) -

En résumé

Nous avons vu que les IA génératives et les moteurs de recherche répondent à des logiques différentes : les premières privilégient la génération de réponses conversationnelles à partir de données préformées, tandis que les seconds organisent l'accès à des sources actualisées. Cette complémentarité explique pourquoi de nouveaux outils hybrides émergent, tentant de combiner le meilleur des deux approches.

Cependant, pour une recherche documentaire rigoureuse, notamment dans un contexte académique ou professionnel, ces distinctions soulèvent des questions importantes sur la fiabilité des sources, la vérification des informations et les méthodes de recherche appropriées. C'est ce que nous allons explorer dans la section suivante.

-