IA et recherche documentaire : ChatGPT et les autres

Résumé de section

-

Cette formation explore l'impact de l'Intelligence Artificielle (IA) sur la recherche documentaire. Elle examine comment les outils d'IA générative transforment nos pratiques de recherche d'information, depuis les évolutions des moteurs de recherche traditionnels jusqu'à l'émergence de nouveaux assistants conversationnels.

Objectifs généraux

- Comprendre le fonctionnement des robots conversationnels et leurs différences avec les moteurs de recherche traditionnels

- Identifier les limites et les biais des IA génératives dans un contexte de recherche documentaire

- Distinguer les différentes approches de recherche (simple, approfondie)

- Analyser de manière critique les réponses fournies par les outils d'IA et vérifier leur fiabilité

Ce cours est en libre accès !

Aucune création de compte ou d'inscription n'est nécessaire, toutefois vous ne pourrez le parcourir qu'en lecture seule.

Pour participer à certaines activités (test, forum...), vous pouvez vous inscrire au cours.

-

La notion d'Intelligence Artificielle (IA) n'est pas récente, mais elle s'est démocratisée en fin d'année 2022 avec le lancement de ChatGPT au grand public. Depuis, les IA génératives ont pris une place considérable dans la vie de millions de personnes, que ce soit dans le cadre de la sphère privée ou professionnelle.

2 minutes de lecture

-

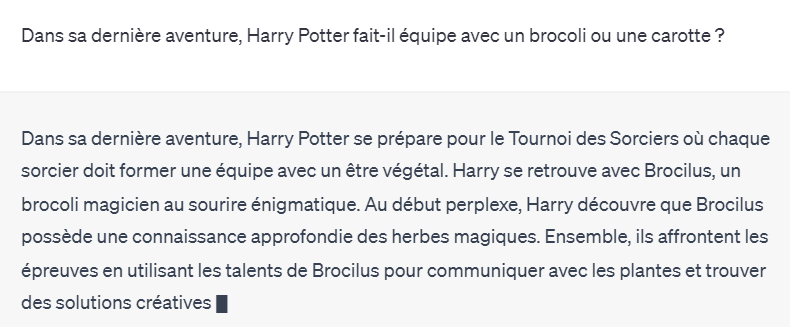

Les IA actuellement connues du grand public sont celles qui peuvent générer des contenus (texte, image, musique, vidéo...), que l'on appelle IA génératives. Certaines sont capables de converser avec nous, on les appelle aussi IA conversationnelles. Elles peuvent ainsi écrire un poème, créer du code informatique, expliquer un concept complexe, tenir une vraie conversation.

15 minutes de lecture

-

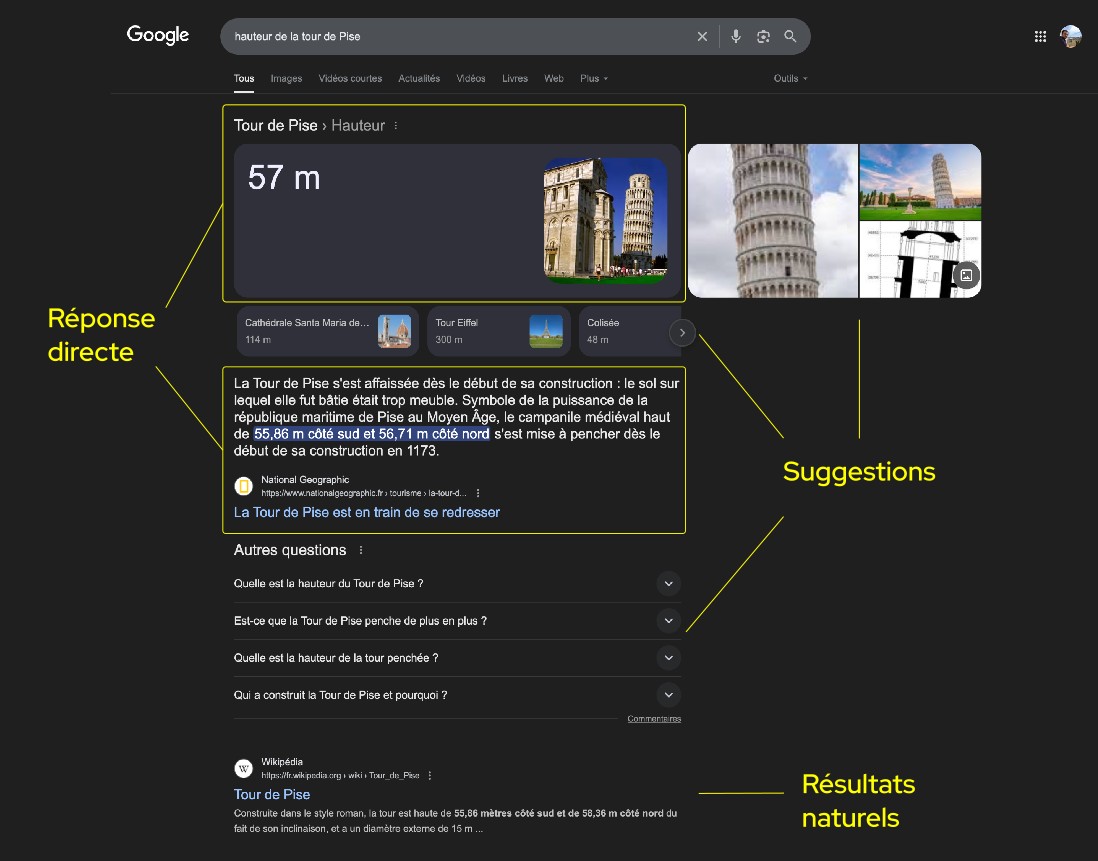

Les IA génératives sont désormais de plus en plus utilisées pour la recherche d'information. Quelles sont les convergences et divergences avec les moteurs de recherche classiques ?

30 minutes de lecture

-

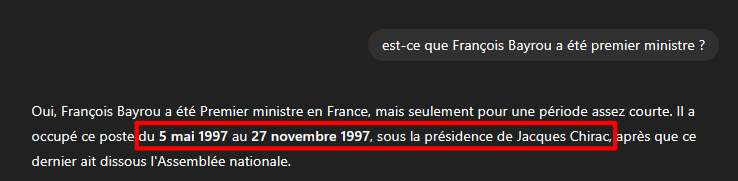

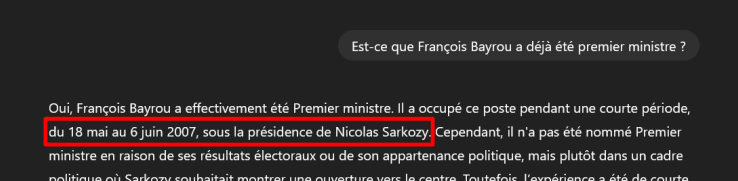

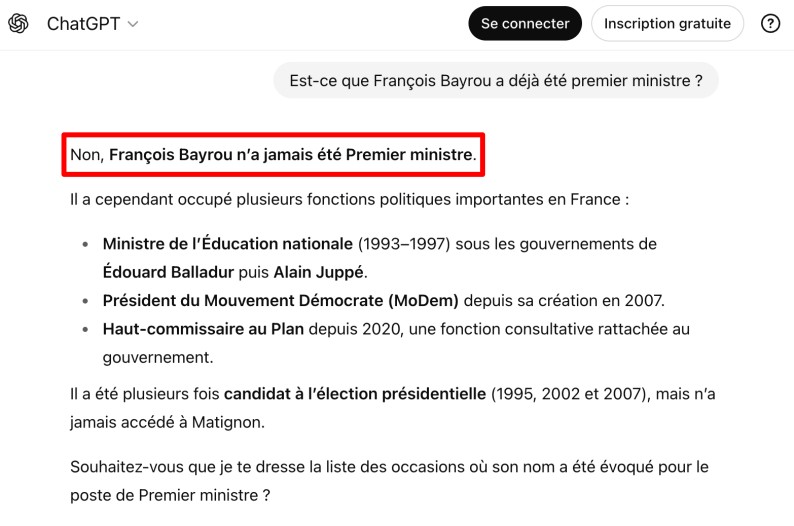

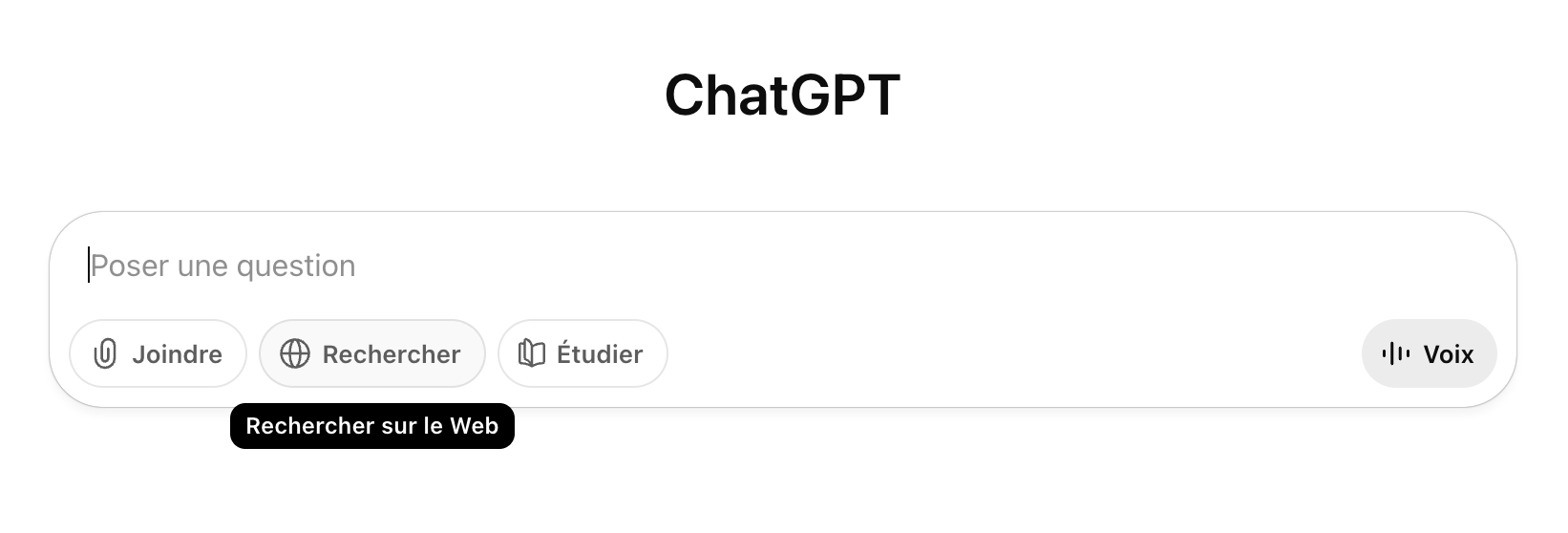

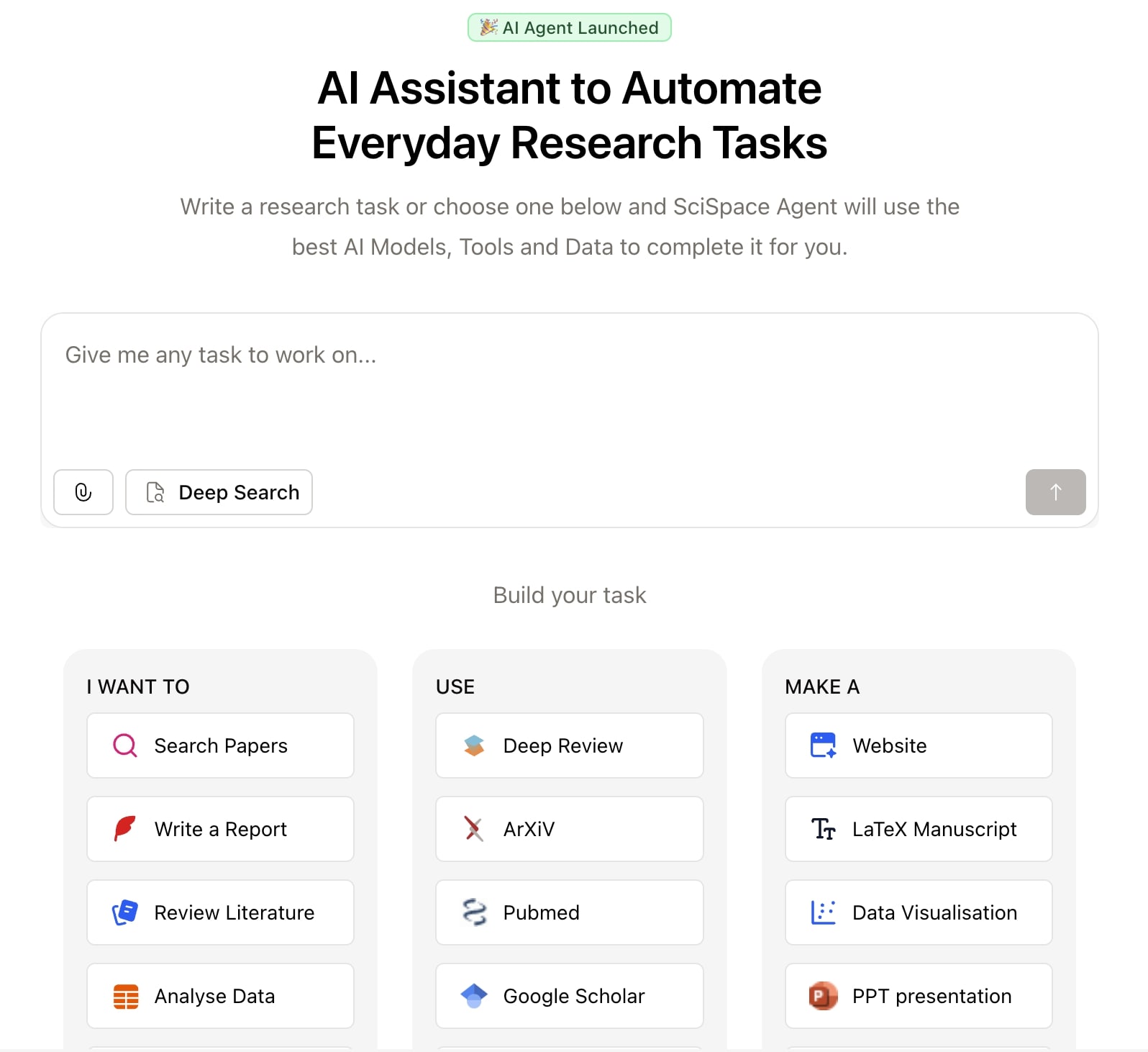

Les chatbots proposent maintenant des fonctions de recherche. Comment ça fonctionne ? Et surtout, est-ce que ça fonctionne ?

40 minutes de lecture

-

Exemple de rapport détaillé généré en 9 minutes par la fonction deep search de ChatGPT 5.

37.5 Ko

-

Tout au long de ce cours, nous avons exploré l'impact des IA génératives sur la recherche documentaire. Nous avons vu qu'elles transforment nos pratiques d'information en proposant des approches conversationnelles et des synthèses rapides, mais qu'elles présentent aussi des limites importantes : hallucinations, biais, manque de reproductibilité et sources parfois peu fiables.

Les fonctions de recherche basées sur le RAG (simple ou approfondie) permettent de pallier certaines de ces limites en s'appuyant sur des bases de connaissances externes actualisées. Toutefois, elles ne remplacent pas une démarche de recherche rigoureuse et critique, essentielle dans un contexte académique ou professionnel.

Dans tous les cas, gardez en tête ces quatre principes :

- comparez différentes requêtes ;

- comparez les outils entre eux ;

- vérifiez systématiquement les réponses des outils (présence de sources, contenus générés) ;

- tenez vous au courant des évolutions des outils que vous utilisez.

-

-

Ce forum est à votre disposition pour tout échange sur le cours. Vos retours sont aussi les bienvenus.

-