1. Introduction

Après un rapide aperçu de ce qu’il était possible de faire avec les contenus et données des projets Wikimedia, ce chapitre aborde les principales sources de données utilisées. Vous découvrirez les points suivants :

- Quelles sont les données existantes ?

- Quelles sont les conditions pour y accéder ?

- Quelles sont les conditions de réutilisation de ces données ?

Le mouvement Wikimedia comprend plus de 1000 sites basés sur la technologie wiki. Le contenu est rédigé dans plus de 300 langues et 35 systèmes d'écritures différents. En tout, cela représente plus de 60 millions d'articles encyclopédique dans les différentes versions linguistiques de Wikipedia, plus de 100 millions de médias dans Wikimedia Commons, des millions de mots de vocabulaire dans les différents versions du Wiktionnaire, etc.

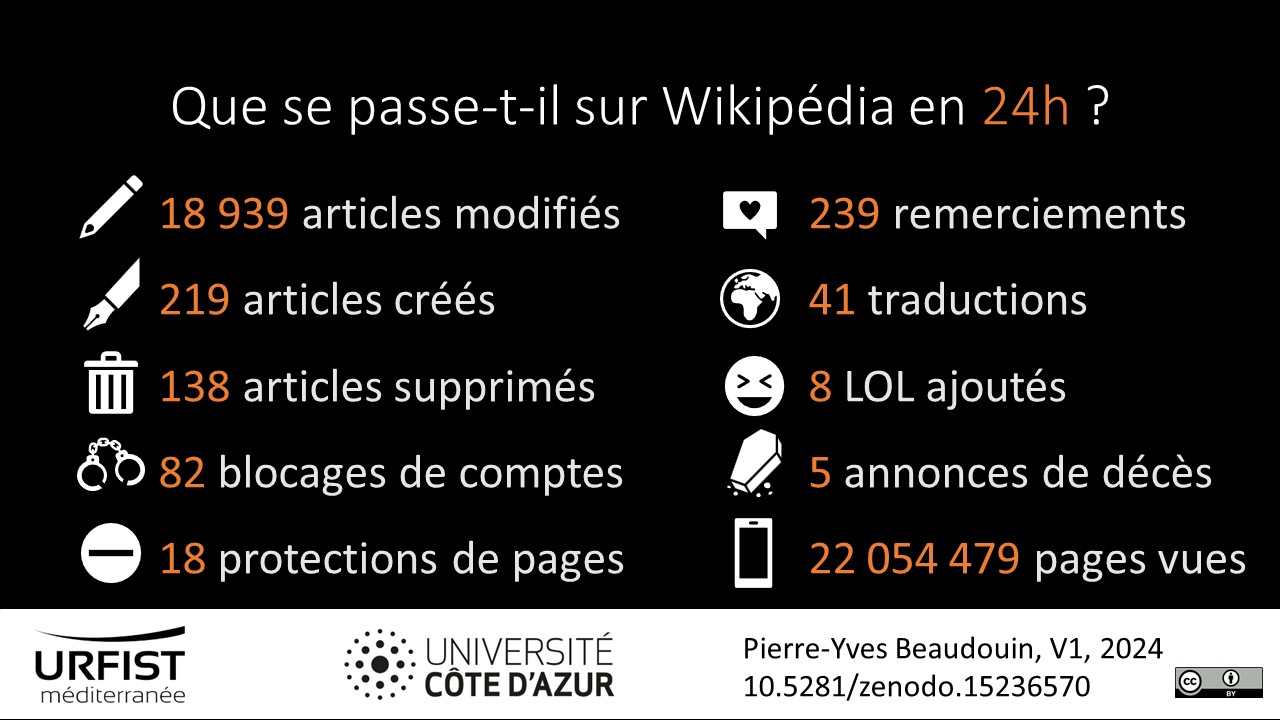

Données statistiques de la Wikipedia francophone. 10.5281/zenodo.15236570

Outre le contenu intrinsèque des projets Wikimedia, la consultation et l'élaboration des wikis génèrent de nombreuses données : nombre de fois qu'une page est consultée, tout un tas de données provenant des serveurs, historique des modifications d'un article et historique des contributions d'un rédacteur, nombre de clics sur un lien, etc. De plus, les chercheurs mettent régulièrement à disposition des jeux de données spécifiques en retravaillant les données extraites des projets Wikimedia, par exemple des jeux de données sur les références bibliographiques utilisées dans Wikipedia ou les personnes célèbres présentes dans l'encyclopédie.

Voici un récapitulatif des sources de données présentées dans ce chapitre et le suivant :

| Source | Contenu | Accès | Format | Actualisation | Quantité | Limites |

|---|---|---|---|---|---|---|

| Wikimedia Foundation dumps | métadonnées contenu relations |

hors ligne | XML SQL |

bimensuelle | données massives | gros volume de données et données au format wikitexte |

| Wikimedia Enterprise dumps | contenu | hors ligne | HTML | mensuelle | données massives | gros volume de données |

| Analytics dumps : jeux de données de l'activité des wikis | pages vues activité |

hors ligne | TSV | mensuelle | données massives | gros volume de données |

| MediaWiki API MediaWiki REST API Wikimedia REST API |

métadonnées contenu relations statistiques |

en ligne | JSON PHP WDDX XML YAML |

temps réel | micro données | pas adapté pour extraire beaucoup de données |

| Wiki replicas : copies en temps réel et nettoyées des bases de données | métadonnées contenu relations |

en ligne | SQL | quasi temps réel | micro données | pas adapté pour extraire beaucoup de données |

| EventStreams : suivi en direct de l'activité des wikis | logs | en ligne | JSON SSE |

temps réel | traitement des données | |

| Wikimedia Statistics : rapports statistiques | pages vues contenu activité |

en ligne | CSV JSON |

mensuelle | micro données | pas adapté pour extraire beaucoup de données |

| dons collectés | en ligne |

CSV |

quotidienne | micro données |

||

| Entrepôts de données : sources extérieures de données | jeux de données spécifiques |

hors ligne |

Source : inspiré du tableau 4 d'Arroyo-Machado, Wenceslao, et al. “Wikinformetrics: Construction and Description of an Open Wikipedia Knowledge Graph Data Set for Informetric Purposes”, Quantitative Science Studies, vol. 3, no. 4, 2022, pp. 931–52.